你也来冥想训练?Bin峡谷之巅账号已有五天没有登入游戏

休息还是和陪练队作战?不敌KT后 TES当日排位到一点 次日却无人Rank

外媒统计:T1对战GEN的比赛海外峰值221万,为今日最高

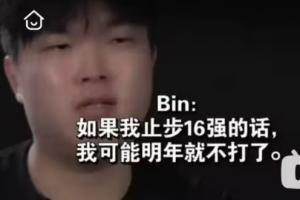

退役边缘还是已经忘了?去年纪录片Bin:如果真16强,我明年就不想打了

Kael:多亏Tarzan哥的帮助,中文水平和游戏理解进步很多

Duro:打AL的BP没做好 今天打T1的BP特别好 除了他们的巴德都不用怕

体育资讯10月4日讯 据 decoder 今天报道,腾讯研究人员最近用《王者荣耀》游戏作为训练平台,探索如何让AI在游戏中学会“战略性思考”,研究全新 TiG(Think in Games)框架,相关成果已发表于 Hugging Face 平台和 arXiv 期刊。

研究团队指出,目前的 AI 模型存在明显的功能鸿沟,以游戏为取向的 AI 能正常游玩但无法理解自己所做的决策,而语言模型虽然可以推理策略,但很难真正执行操作,为此他们研发了全新 TiG 框架,让模型在游戏中同步思考、行动。

团队选择以《王者荣耀》游戏作为训练范本,先使用匿名且标准化的赛事数据定义推上路、击杀暴君、守家等 40 种宏观行动,胜负回数均衡,AI 模型们必须要在每个定义好的场景下选择最佳策略,并解释其战略缘由。

具体来说,训练分为两个阶段,首先是在监督中学习,弄清楚这些策略的基本机制;随后通过奖励机制进行强化学习,如果行动正确能得 1 分,错误行动则得 0 分。

随后团队测试了多种语言模型,涵盖 Qwen2.5(7B、14B、32B)、Qwen3-14B 模型,并使用 DeepSeek-R1 大模型作为对照组;先从 DeepSeek-R1 提炼高质量训练数据,然后使用群体相对策略优化(GRPO)技术,比较不同策略之间的优劣。

最终经过 TiG 框架训练的模型不仅能制定行动计划,还能解释原因,例如 AI 会指出某个防御塔防守薄弱,是理想的进攻目标,但需要注意埋伏的敌人。模型训练后仍保持原有的文本理解、数学推理与问答能力。

最终测试结果如下:

对照组 DeepSeek-R1:决策准确率达 86.67%

Qwen3-14B:决策准确率达 90.91%,超越 DeepSeek-R1

Qwen2.5-32B :准确率从 66.67% 提升至 86.84%

Qwen2.5-14B:准确率从 53.25% 提升至 83.12%